就比如之前那个帖子下面的这些回复:

zhower

按说电脑的逻辑思维应该更强点,毕竟是理科生写出的架构

zhower

按说电脑的逻辑思维应该更强点,毕竟是理科生写出的架构

jilaqi444

我以为ai都会满分,不是链接的大数据吗。

jilaqi444

我以为ai都会满分,不是链接的大数据吗。

AI 这个东西本来就比较奇怪,现在这些企业什么的还疯狂推销,把这玩意都捧上天了,所以有误解也正常。但是为了不被这些公司的宣传骗到,还是消除一下误解比较好。坛里肯定有很多比我懂得多的大佬,我就胡写一点,叫各位见笑了。

首先一般我们提到 “AI”这个词,估计首先想到的是 HAL 9000、GLaDOS、科塔娜这种似人非人、和人类一样有逻辑思考能力的。这种可以算作是“强人工智能”,目前只是科幻作品的想象,还没有任何能实现它的技术或理论。我们现在有的这些 ChatGPT、Stable Diffusion、Sora 之类的都可以算作“弱人工智能”,是用专门的数据集来训练、训练出来只能干某些专门的事的算法。比如识别图片的特征(看图里是个猫还是个狗什么的)、分析数据、生成文字之类。当然这个分类本身也只是一种理论,谁知道未来会发展成什么样。

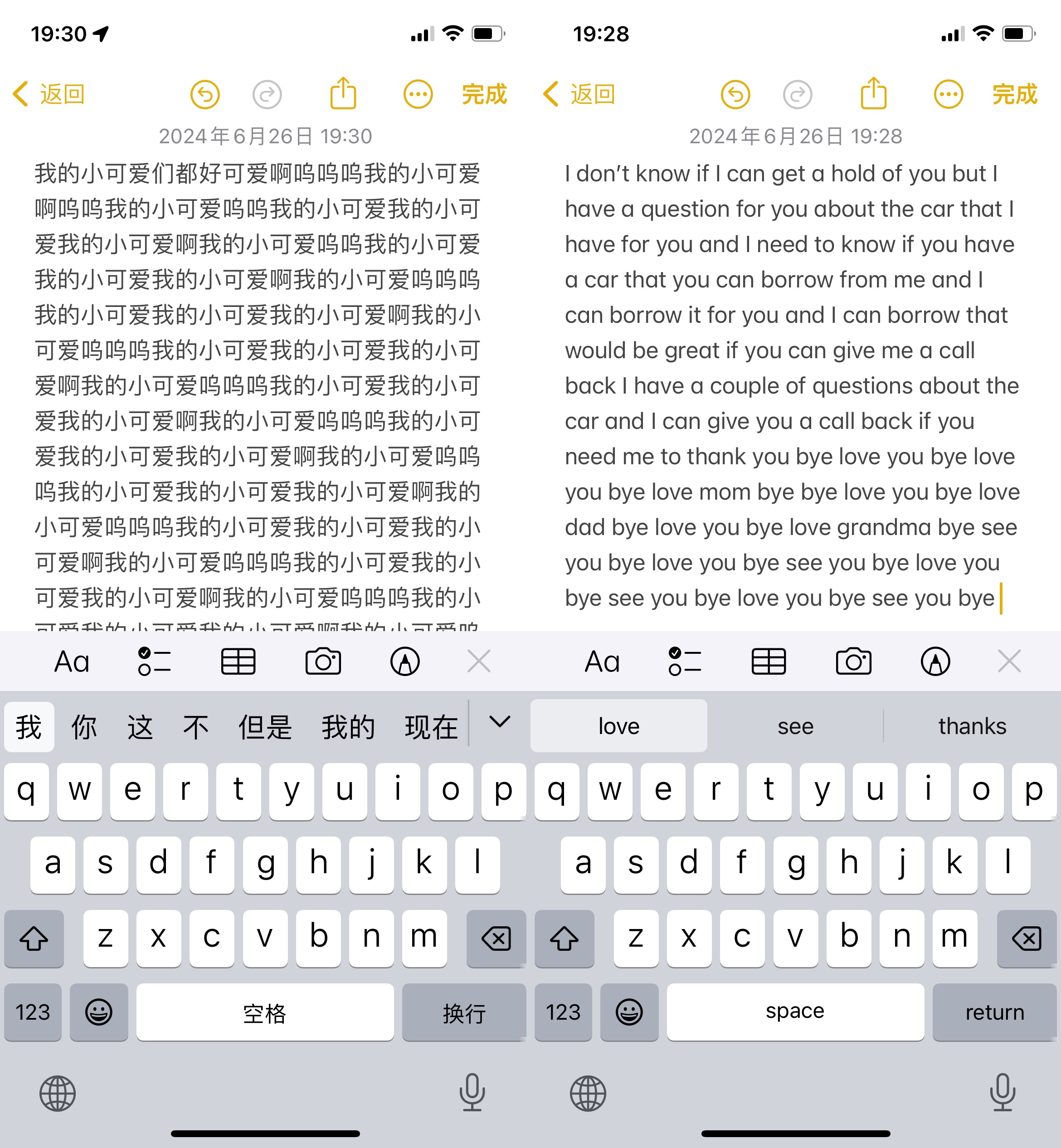

上一个帖子 LLM 高考成绩 里说到的 LLM(Large Language Model,大语言模型)就是后者,包括现在市面上所有这些生成文字的“AI”,比如 ChatGPT 这种。这些模型实际上能做的只是预测文字,背后是没用任何逻辑、计算能力的。至于预测文字到底是什么意思,举个更常见的东西作例子,就类似你输入法对你要打的下一个字的预测:

这是我从“我”和 “I”开始,不管出来啥都选第一个选项,连着点了一堆打出来的。可以看到这样其实可以写出一两句还算通顺的,但是到最后就陷入重复了。你的输入法能知道你前面输入的一个或两个字,然后用统计数据来预测你下个要输入的字。LLM 也是一样的基于概率统计,但通过训练它能有更好的预测对的几率,通过更庞大的训练数据统计结果也更有代表性,而且最关键的是 LLM 知道你说过的话和自己生成的话的上下文,所以它一般不会和输入法一样陷入重复或写出特别离谱的东西(当然偶尔也会)。

LLM 的训练也不是什么诞生逻辑的过程,比如你给它一个 “the sky is”, 它猜“red”就给它惩罚,猜“blue”就给它奖励,这样它下次看见 sky 这类的词就会更偏向 blue 这样的预测。如此往复训练它个几千几亿次,就能建立一个词汇之间相互关联程度网络。(说白了只是概率分布而已,不是和第二个评论里想的,背后链接着什么神奇大数据。数据量本身也是有限的,训练不到就是不知道,不是整个人类的知识都在里面了。)下次它看见 “my cat is sitting on the”,注意到 cat 和 sitting,从训练好的数据里一看有这个两个词的情况下后面 “mat”最常出现,就能给你生成出“my cat is sitting on the mat”这种句子。但是它知道什么是猫、什么是坐、什么是垫子吗?当然不知道,它连 sit 和 sitting 是同一个词都不知道,只知道 cat 后面更可能出现的词是其中哪一个。刚刚“注意”这个词,很大程度上就是 GPT 这种 LLM 这么厉害的背后原理。具体我学艺不精,讲不明白。总之就是这种对上下文、自己生成的东西的注意力为 LLM 提供了一种短期记忆,这样它在生成代码的过程中能一直持续生成你想要的代码,而不是生成到一半把它忘了,改去生成我的小可爱呜呜呜了。

所以总之就是,这玩意不像一些公司吹的这么强,LLM 是没有所谓逻辑能力的,只是从现有数据中预测,这就是为什么它能做有充足训练资料、套路都一样的文科卷子。但是理科并不能靠预测,我给你个 3.14,你靠预测也许能从之前的训练里推测出后面是 159,但是继续往后算 π 这种真正的计算它做不到。我之前拿一个化学反应考它,因为网上有一些关于这个反应的描述,它能说出反应的产物,但是问它机理什么的是完全答不出来。尤其是给它一个没见过的化学式叫它配平,是一点也配不对,数字全是胡诌的,因为这种纯逻辑的东西是不能靠读上下文来从字里行间“预测”出来的。

上一篇:

路易鬼屋2HD偷跑下一篇:

【职场那点事】老板钥匙被偷了